Potwierdzam, a próbowaliśmy Rift CV1, Pimaxa 5k+ (wszystkie tryby), OG Vive, Questa, Odyssey+, Lenovo oraz Indexa. @SimplexPL jeszcze PSVR... Ale spoko, różnice są "nieznaczne". Tylko że nieJa tam widzę różnicę na plus w FOV między Indexem a każdym innym headsetem (oprócz pimaxa który ma największy FOV). Index ma też szeroki FOV pionowy,a nie tylko poziomy.

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Przygody z Virtual Reality

- Thread starter VR StarLightPL

- Start date

-

- Tags

- htc vive oculus quest valve index vr wmr

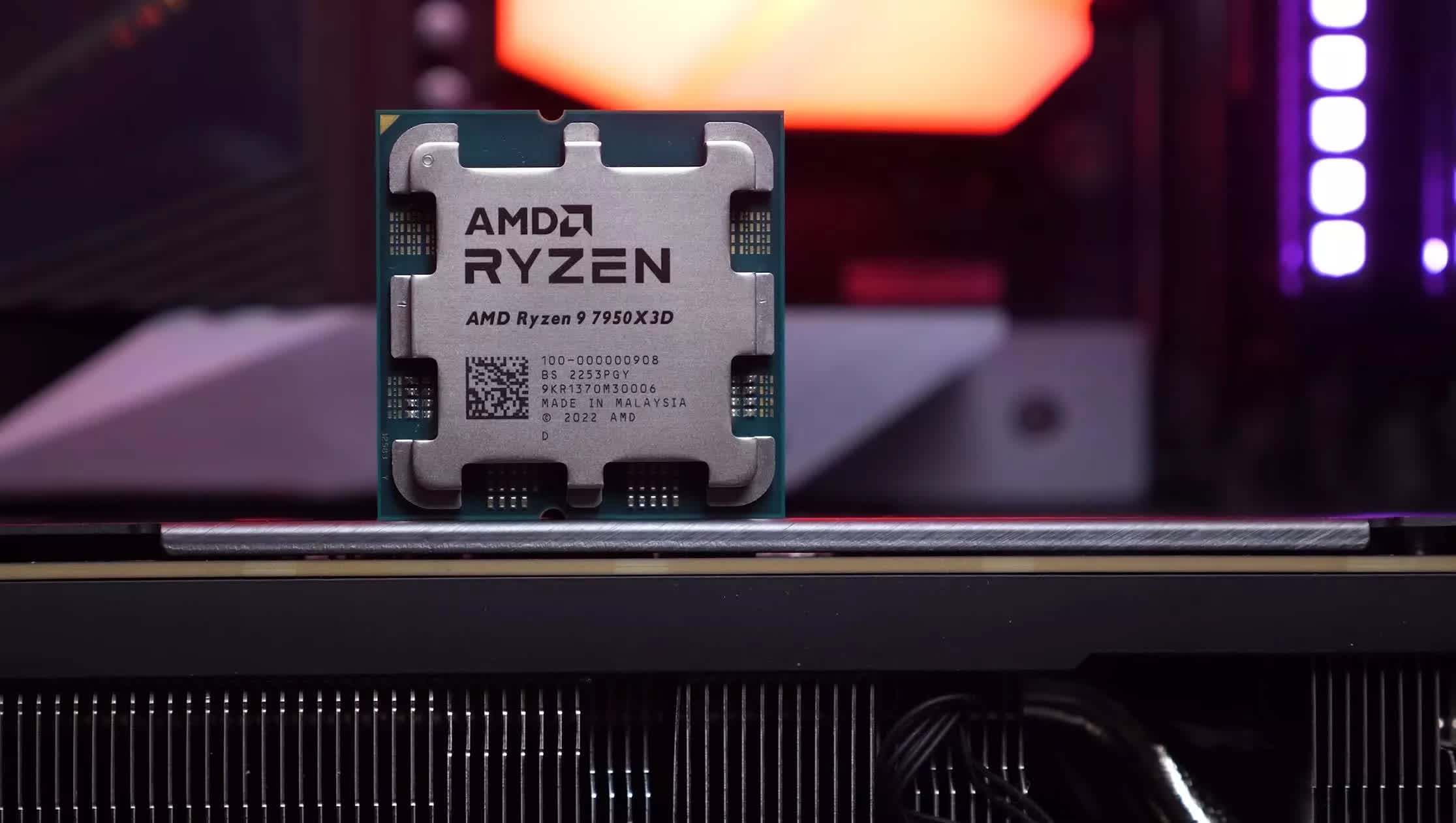

Ponizej pierwsza instalacja karty RTX Founders Ed. gdzies w europie centralnej

A ja się zastanawiałem cały czas czemu tę cenę taką "niską" zrobili, skoro mogli spokojnie wyżej celować (przynajmniej wg opinii posiadaczy 2080  )

)

I mi ten artykuł sprawę rozjaśnił:

www.gry-online.pl

www.gry-online.pl

I mi ten artykuł sprawę rozjaśnił:

Nvidia wygrała - biorę GeForce RTX 3080 zamiast PS5 czy Xbox Series X | GRYOnline.pl

Piękny dylemat będzie stał przed nami w tym roku: PS5, Xbox Series X, czy może GeForce RTX 3070 lub RTX 3080? Po wczorajszej prezentacji w wykonaniu firmy Nvidia chyba już mam odpowiedź.

Last edited:

To też ma wpływ - chcą zgarnąć część tortu. Ale jednak standalone konsole w cenie karty graficznej to IMHO inny rynek. Może wreszcie AMD coś pokaże?

Source: https://www.youtube.com/watch?v=s5T1uAEbMuE

PS: Za stary jestem żeby wierzyć w comeback AMD, ale byłoby fajnie.

PS: Za stary jestem żeby wierzyć w comeback AMD, ale byłoby fajnie.

Z treści wynika że i tak by konsol nie kupił bo nie umie grać na padzie, więc nagłówek to clickbait.

Nvidia zdała sobie sprawę że jakby znowu wyskoczyła z absurdalnie drogimi kartami które nie oferują praktycznie żadnego przyrostu wydajności w stosunku do poprzedniej generacji w tym samym przedziale cenowym (pozdro Turing) to w momencie gdy na rynku pojawią się konsole od Sony i MS w cenie ok 500$, to większość graczy wybierze konsole, bo hardkorowych pecetowcow brzydzących się konsolami jest garstka. Więc nieprzypadkowo 3070 ma kosztować tyle ile spodziewana cena konsol

Dwa lata temu mogli to zrobić bo nie było alternatywy. Teraz będą to zarówno konsole jak i karty AMD które mogą trochę namieszać (na pewno będą mniej prądożerne).

Nvidia zdała sobie sprawę że jakby znowu wyskoczyła z absurdalnie drogimi kartami które nie oferują praktycznie żadnego przyrostu wydajności w stosunku do poprzedniej generacji w tym samym przedziale cenowym (pozdro Turing) to w momencie gdy na rynku pojawią się konsole od Sony i MS w cenie ok 500$, to większość graczy wybierze konsole, bo hardkorowych pecetowcow brzydzących się konsolami jest garstka. Więc nieprzypadkowo 3070 ma kosztować tyle ile spodziewana cena konsol

Dwa lata temu mogli to zrobić bo nie było alternatywy. Teraz będą to zarówno konsole jak i karty AMD które mogą trochę namieszać (na pewno będą mniej prądożerne).

Video mówi też o cenie, o której się na zlocie Veyrona również nie gada, ale co poniektórzy chodzą twardo po ziemi i lubią mieć alternatywyRozmowa o prądożerności w kontekście GPU to jeszcze niż niższy stan niż rozmowa o spalaniu na zlocie Veyrona.

Tak czy siak - na emejzonie G2 skoczył do 700 eur.

Poziom absurdalności tego porównania mnie przerósł. Karty które zużywają bardzo dużo mocy w stosunku do wydajności potrzebują mocnych sekcji zasilających oraz zaawansowanego chłodzenia. Obie te rzeczy zwiększają koszt dla klienta, a jeśli producent na nich oszczędzi to karta będzie głośna i/lub będzie podgrzewać komputer od środka. Czyli klient będzie miał gorzej.Rozmowa o prądożerności w kontekście GPU to jeszcze niż niższy stan niż rozmowa o spalaniu na zlocie Veyrona.

Od kilka lat karty AMD są dużo mniej enerogoszczędne niż karty nvidii i zupełnie przypadkowo słabo się też sprzedają.

Karty AMD się nie sprzedają nie dlatego bo są prądożerne. Ja mam gdzieś prądożerność i rachunek za prąd. Karty AMD się nie sprzedają dlatego bo gry są optymalizowane pod NVIDIĘ i nie ma w tym żadnej tajemnicy że Nvidia kupuje ten temat, ale nic też nie stoi na przeszkodzie żeby AMD położyło kapustę.

Druga strona medalu jest taka, że AMD od zawsze, ma pokazać BOMBĘ, która już za kilka miesięcy wyjdzie, i rozwali zarówno Intela jak i Nvidię w proch. I tak od pewnie 30 lat, i zarówno Intel jak i Nvidia, mimo droższego sprzętu, szermanej opinii, mają się całkiem dobrze i nie ma większego problemu z ich sprzętem.

Jakby AMD rzeczywiście pokazało bombę, to bym ją kupił zamiast 3080/3090, ale się nie zanosi, prawdopodobnie będą grać z 3060.

Druga strona medalu jest taka, że AMD od zawsze, ma pokazać BOMBĘ, która już za kilka miesięcy wyjdzie, i rozwali zarówno Intela jak i Nvidię w proch. I tak od pewnie 30 lat, i zarówno Intel jak i Nvidia, mimo droższego sprzętu, szermanej opinii, mają się całkiem dobrze i nie ma większego problemu z ich sprzętem.

Jakby AMD rzeczywiście pokazało bombę, to bym ją kupił zamiast 3080/3090, ale się nie zanosi, prawdopodobnie będą grać z 3060.

Last edited:

W ciągu ostatnich 30 lat amd wielokrotnie miało lepsze karty od nvidii (na przykład R300 w czasach GeForce FX), ale nvidia ma więcej pieniędzy na marketing i propagandę, czego efektem są takie posty jak ten wyżej. To samo z Intelem. Obecnie procesory AMD są lepsze od intela pod praktycznie każdym względem oprócz gier (gdzie są minimalnie słabsze), ale Intel ma więcej pieniędzy na propagandę.

Jeszcze napisz że kominku palisz dolaramiprądożerne. Ja mam gdzieś prądożerność i rachunek za prąd.

Ta, w Excelu. Widzę że świadoma ignorancja teraz w modzie. Nawet mi się nie chce z tym polemizować, bo to jakby dyskutować z płaskoziemcą albo antyszczepionkowcem lub innym trolem przekonanym o swojej nieomylności.

Wrzucę jednego linka i na tym zakończę.

www.techspot.com

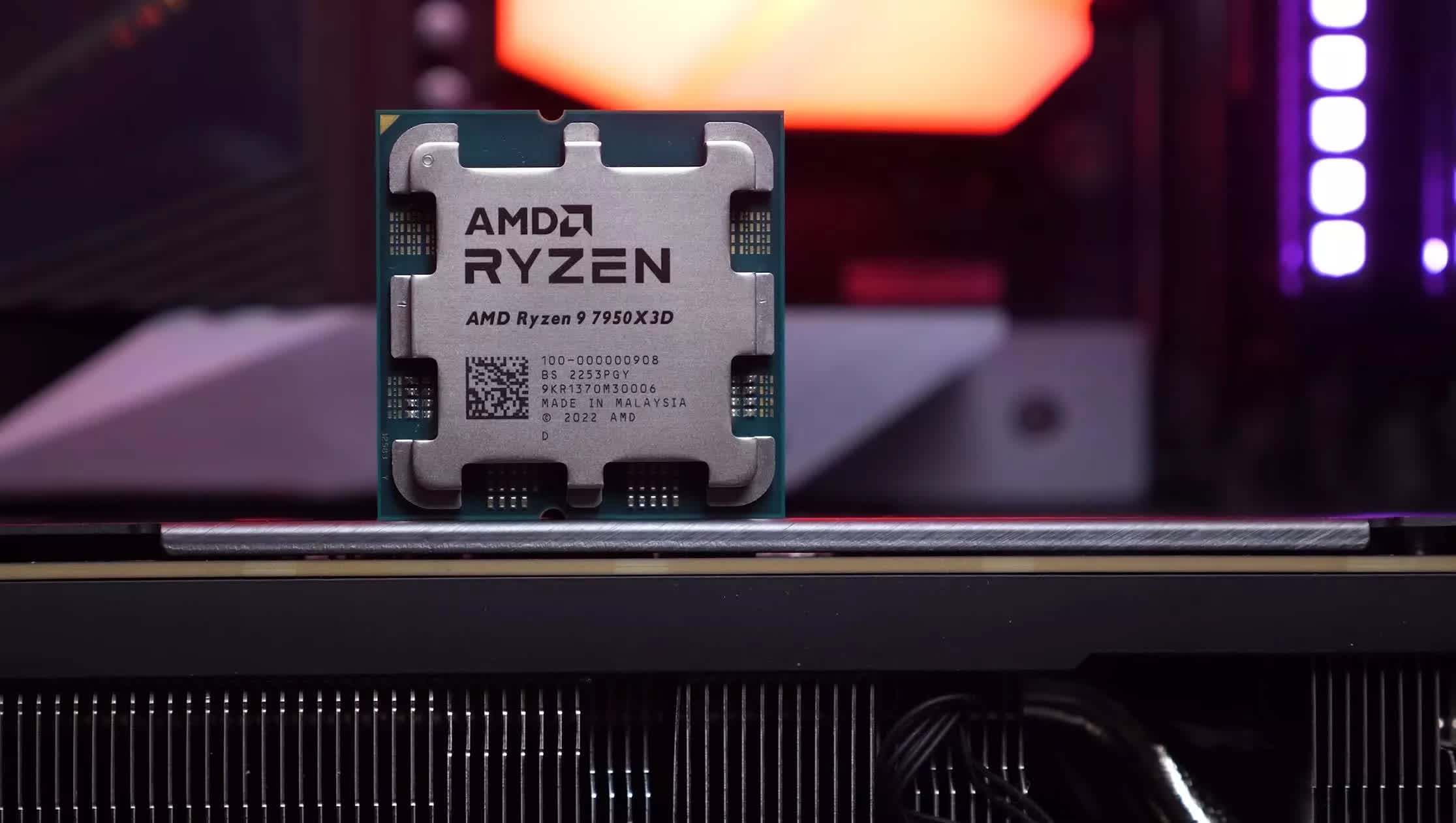

A za chwilę wyjdą procesory Zen 3 (Ryzen 4000) które będą jeszcze lepsze.

www.techspot.com

A za chwilę wyjdą procesory Zen 3 (Ryzen 4000) które będą jeszcze lepsze.

EDIT: zanim ktoś zapyta, to mam Intela, a ostatni procesor AMD miałem z 15 lat temu Do premiery Ryzena procesory AMD to był szmelc, ale już nie jest. Sytuację dobrze obrazuje wykres wzrostu kursu akcji AMD vs akcje intela - gdyby AMD miało dziadowskie procki, to ich kurs akcji nadal szorowałby po dnie jak kilka lat temu (akcje AMD bardzo długo kosztowały poniżej 5 dolarów, firma była o krok od bankructwa - jak ktoś wtedy kupił te akcje, to wygrał życie, bo obecnie jedna akcja warta jest 80 dolarów).

Do premiery Ryzena procesory AMD to był szmelc, ale już nie jest. Sytuację dobrze obrazuje wykres wzrostu kursu akcji AMD vs akcje intela - gdyby AMD miało dziadowskie procki, to ich kurs akcji nadal szorowałby po dnie jak kilka lat temu (akcje AMD bardzo długo kosztowały poniżej 5 dolarów, firma była o krok od bankructwa - jak ktoś wtedy kupił te akcje, to wygrał życie, bo obecnie jedna akcja warta jest 80 dolarów).

Znaczenie finansowe prądożerności to chochoł którego sobie wymyśliłeś, ja nic o kosztach prądu nie pisałem (bo są pomijalne i nigdy nie twierdziłem inaczej), tylko o tym że prądożerna karta się grzeje, więc osiąga niższe zegary, do tego podgrzewa wnętrze komputera, w tym procesor (znowu - wyższa temperatura to niższe zegary), więc wymaga dużego i drogiego chłodzenia no i hałasuje, a ja wolę ciszę od hałasu.

Dla mnie zużucie prądu też nie ma znaczenia, pod warunkiem że karta która zużywa dużo prądu jest zaprojektowana w taki sposób, żeby dużą ilość ciepła którą generuje efektywnie i cicho wypchać poza obudowę. Wtedy w zimie może robić za farelkę, a w upalne lato będzie dodatkowo podwyższać temperaturę otoczenia i wymagać schłodzenia klimatyzacją (co już swoje kosztuje).

Wrzucę jednego linka i na tym zakończę.

The Best CPUs: Productivity and Gaming

After reviewing CPUs throughout the year and revisiting the most interesting matchups post-launch, in this buying guide we put it all together to keep your CPU shopping...

www.techspot.com

www.techspot.com

EDIT: zanim ktoś zapyta, to mam Intela, a ostatni procesor AMD miałem z 15 lat temu

Znaczenie finansowe prądożerności to chochoł którego sobie wymyśliłeś, ja nic o kosztach prądu nie pisałem (bo są pomijalne i nigdy nie twierdziłem inaczej), tylko o tym że prądożerna karta się grzeje, więc osiąga niższe zegary, do tego podgrzewa wnętrze komputera, w tym procesor (znowu - wyższa temperatura to niższe zegary), więc wymaga dużego i drogiego chłodzenia no i hałasuje, a ja wolę ciszę od hałasu.

Dla mnie zużucie prądu też nie ma znaczenia, pod warunkiem że karta która zużywa dużo prądu jest zaprojektowana w taki sposób, żeby dużą ilość ciepła którą generuje efektywnie i cicho wypchać poza obudowę. Wtedy w zimie może robić za farelkę, a w upalne lato będzie dodatkowo podwyższać temperaturę otoczenia i wymagać schłodzenia klimatyzacją (co już swoje kosztuje).

Last edited:

Ale z tego co podałeś w zasadzie nic nie wynika konkretnego.

Nigdzie też nie pisałem co jest lepsze i kiedy, jedynie że AMD to firmwa która za chwile ma pozamiatać intela i nvidię, (od 30 lat ), faktycznie ta bomba nigdy nie wyszła, niczego nie zamiotła, niektóre produkty byly rzeczywiście zbliżone, niektóre troche lepsze, ale jakoś niespecjalnie widać rzekoma 'lepszość' AMD przekłada się na ich udział w rynku.

A rynek, wie co jest dla niego lepsze.

Nigdzie też nie pisałem co jest lepsze i kiedy, jedynie że AMD to firmwa która za chwile ma pozamiatać intela i nvidię, (od 30 lat ), faktycznie ta bomba nigdy nie wyszła, niczego nie zamiotła, niektóre produkty byly rzeczywiście zbliżone, niektóre troche lepsze, ale jakoś niespecjalnie widać rzekoma 'lepszość' AMD przekłada się na ich udział w rynku.

A rynek, wie co jest dla niego lepsze.

A ja już Ci pisałem że w ciągu ostatnich 30 lat AMD kilkukrotnie miało lepsze karty od Nvidii (sprawdź sobie co to był radeon 9700Pro i co to był GeForceFX 5800 to może przestaniesz powtarzać nieprawdziwe informacje), ale Nvidia miała lepszą machinę propagandową, a ludzie mają krótką pamięć.

Source: https://www.youtube.com/watch?v=0dEyLoH3eTA

Skoro rynek wie co jest dla niego lepsze, no to rynek akcji również wie. Więc jak wytłumaczysz ten wykres?

Kurs akcji Intela: 49$

Kurs akcji AMD: 80$ - prawie dwa razy wyższa. Rynek wie

Kapitalizacja rynkowa intela: 211 mld $

Kapitalizacja rynkowa AMD: 90 mld $ - czyli prawie połowa tego co intel, a jeszcze pare lat temu to było nie do pomyślenia, AMD było karzełkiem w porównaniu z intelem. Miesiac temu kapitalizacja przekroczyła 100 mld $.

Rynek też to wie i dlatego udział procesorów AMD w rynku rośnie i jest najwyższy od 7 lat.

www.tweaktown.com

www.tweaktown.com

Na rynku mobilnym też zaczynają sobie dobrze radzić, dzięki temu że mają dostęp do najnowszego procesu TSMC 7nm a intel i nvidia nie.

www.techspot.com

www.techspot.com

I mam nadzieję, że zauważasz sprzeczność w jednoczesnym twierdzeniu że "rynek wie co jest dla niego dobre" i "gry są optymalizowane pod NVIDIĘ i nie ma w tym żadnej tajemnicy że Nvidia kupuje ten temat" - czyli nvidia (i intel) przekupuje i monopolizuje rynek, a nie "rynek wie lepiej". W sytuacji prawie że monopolu rynek nie zachowuje się racjonalnie, bo to monopolista dyktuje warunki.

Source: https://www.youtube.com/watch?v=osSMJRyxG0k

Source: https://www.youtube.com/watch?v=H0L3OTZ13Os

Skoro rynek wie co jest dla niego lepsze, no to rynek akcji również wie. Więc jak wytłumaczysz ten wykres?

Kurs akcji Intela: 49$

Kurs akcji AMD: 80$ - prawie dwa razy wyższa. Rynek wie

Kapitalizacja rynkowa intela: 211 mld $

Kapitalizacja rynkowa AMD: 90 mld $ - czyli prawie połowa tego co intel, a jeszcze pare lat temu to było nie do pomyślenia, AMD było karzełkiem w porównaniu z intelem. Miesiac temu kapitalizacja przekroczyła 100 mld $.

Rynek też to wie i dlatego udział procesorów AMD w rynku rośnie i jest najwyższy od 7 lat.

AMD hits Intel again: highest x86 CPU market share since 2013

AMD is dominating in multiple fights, winning back the most x86 CPU market share its had since Q4 2013 thanks to Ryzen CPUs.

Na rynku mobilnym też zaczynają sobie dobrze radzić, dzięki temu że mają dostęp do najnowszego procesu TSMC 7nm a intel i nvidia nie.

AMD Ryzen 7 4800U Review

Today's review is all about the Ryzen 7 4800U, AMD's top-of-the-line APU for lightweight laptops, also known as ultrabooks. This is the best Renoir die AMD has...

www.techspot.com

www.techspot.com

I mam nadzieję, że zauważasz sprzeczność w jednoczesnym twierdzeniu że "rynek wie co jest dla niego dobre" i "gry są optymalizowane pod NVIDIĘ i nie ma w tym żadnej tajemnicy że Nvidia kupuje ten temat" - czyli nvidia (i intel) przekupuje i monopolizuje rynek, a nie "rynek wie lepiej". W sytuacji prawie że monopolu rynek nie zachowuje się racjonalnie, bo to monopolista dyktuje warunki.

Last edited:

Ale To tylko potwierdza to co napisałem.

Gdzie jest karta od AMD która kładzie 1080ti, 2080ti czy 3080? O 3090 nie wspominam.

dlaczego nadal są w niszy?

nie ma nigdzie w twierdzeniu sprzeczności musiałbyś wykazać że jest a nie zrobiłeś tego.

musiałbyś wykazać że jest a nie zrobiłeś tego.

jeszcze raz zatem, z drugiej strony patrząc - co jest niewłaściwego w tym że firma współpracuje z developerami by dostarczyć klientom lepiej zoptymalizoeane gry?

co stoi na przeszkodzie by AMD tak skutecznie współpracowało?

Gdzie jest karta od AMD która kładzie 1080ti, 2080ti czy 3080? O 3090 nie wspominam.

dlaczego nadal są w niszy?

nie ma nigdzie w twierdzeniu sprzeczności

jeszcze raz zatem, z drugiej strony patrząc - co jest niewłaściwego w tym że firma współpracuje z developerami by dostarczyć klientom lepiej zoptymalizoeane gry?

co stoi na przeszkodzie by AMD tak skutecznie współpracowało?

Last edited:

Dyskusja była o procesorach AMD które są dobre tyko w Excelu, a teraz sobie przeskoczyłeś na GPU. Ja nic nie mówiłem o współczesnych kartach AMD lepszych od kart nvidii, a o procesorach. Może pokażą coś ciekawego pod koniec roku a może nie. Układy w konsolach dają nadzieję że to będzie coś ciekawego.

Ale twierdzenie że przez ostatnie 30 lat AMD (wcześniej ATI) nigdy nie miało karty lepszej niż nvidia to bzdura - miało kilkukrotnie.

Między innymi to stoi na przeszkodzie że nvidia ma więcej kasy i zasobów więc może np wydelegować zespół inżynierów żeby siedzieli u klienta i optymalizowali pod nvidie. Pozostałe powodu są w materiale wideo z AdoredTV o nvidii którego nie obejrzysz

Ale twierdzenie że przez ostatnie 30 lat AMD (wcześniej ATI) nigdy nie miało karty lepszej niż nvidia to bzdura - miało kilkukrotnie.

Między innymi to stoi na przeszkodzie że nvidia ma więcej kasy i zasobów więc może np wydelegować zespół inżynierów żeby siedzieli u klienta i optymalizowali pod nvidie. Pozostałe powodu są w materiale wideo z AdoredTV o nvidii którego nie obejrzysz

Dyskusja była o AMD, przeskoczyleś na procesory, tam niespecjalnie bylo o czym rozmawiać bo nadal udział AMD jest niski, to wracamy do GPU.

Czy procesory są lepsze? No niespecjalnie to wynika z tego co dałeś. Są w zasadzie jedynie tańsze. Nigdy też nie pisałem że procesory są złe.

Natomiast, robiłem rozkmine jak kupowałem 9700K. Chciałem kupić AMD, ale finalnie wziąłem Intela, nie dlatego że jestem fanem Intela - otóż nie jestem - pół życia miałem procesory AMD, ale dlatego bo zwyczajnie był szybszy wg testów.

Nie twierdziłem że nigdy AMD nie miało czego lepszego. Miało AMD K6-2 i K6-3, Athlony XP były niezłe, ale zawsze to była jakaś partyzantka, że z jakimś mykiem działało.

I tak przez 30 lat. W kwestii GPU podobnie. Ciągle ta zła Nvidia im szyki psuje kupując testy, płatnych jutuberów, płatnych dziennikarzy a na sam koniec jak śmią śmieć robić wydajniejsze karty i jeszcze chcieć za nie worek pieniędzy. No może by nie chcieli worka pieniędzy jakby konkurencja była... a nie czekaj

Im lepsze produkty będzie AMD mieć, tym dla wszystkich lepiej. Konkurencja jest zawsze dobra dla klienta.

Czy procesory są lepsze? No niespecjalnie to wynika z tego co dałeś. Są w zasadzie jedynie tańsze. Nigdy też nie pisałem że procesory są złe.

Natomiast, robiłem rozkmine jak kupowałem 9700K. Chciałem kupić AMD, ale finalnie wziąłem Intela, nie dlatego że jestem fanem Intela - otóż nie jestem - pół życia miałem procesory AMD, ale dlatego bo zwyczajnie był szybszy wg testów.

Nie twierdziłem że nigdy AMD nie miało czego lepszego. Miało AMD K6-2 i K6-3, Athlony XP były niezłe, ale zawsze to była jakaś partyzantka, że z jakimś mykiem działało.

I tak przez 30 lat. W kwestii GPU podobnie. Ciągle ta zła Nvidia im szyki psuje kupując testy, płatnych jutuberów, płatnych dziennikarzy a na sam koniec jak śmią śmieć robić wydajniejsze karty i jeszcze chcieć za nie worek pieniędzy. No może by nie chcieli worka pieniędzy jakby konkurencja była... a nie czekaj

Im lepsze produkty będzie AMD mieć, tym dla wszystkich lepiej. Konkurencja jest zawsze dobra dla klienta.

Last edited: